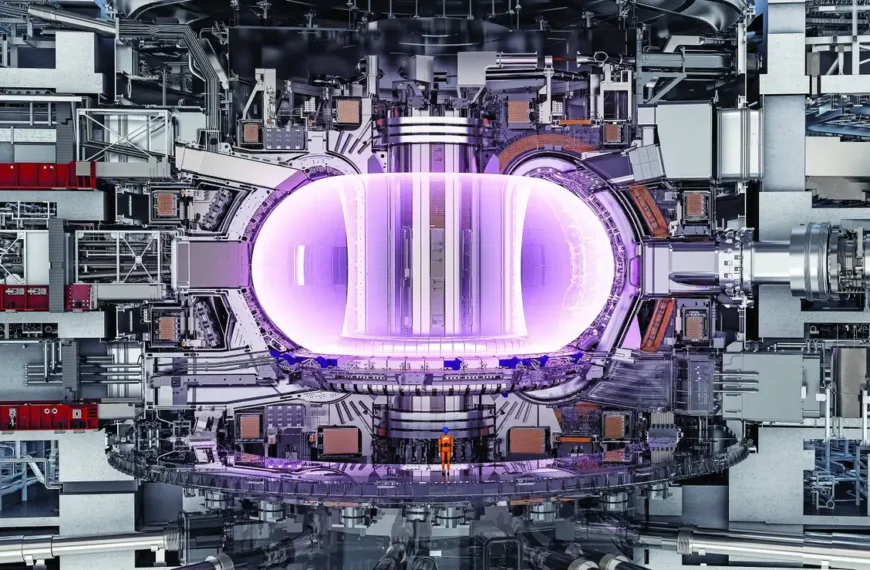

La inteligencia artificial (IA) avanza a pasos de gigante y el mundo laboral está a punto de vivir una transformación sin precedentes. Anthropic, una de las empresas líderes en desarrollo de IA, ha lanzado una advertencia que no podemos ignorar: dentro de un año comenzaremos a ver empleados virtuales con IA trabajando en las empresas. Y no, no es una buena noticia para la ciberseguridad.

🚨 ¿Qué son los empleados virtuales con IA?

Se trata de agentes autónomos controlados por inteligencia artificial que, lejos de limitarse a tareas repetitivas, tendrán memoria, funciones específicas dentro de la empresa e incluso sus propias cuentas y contraseñas corporativas. Según Jason Clinton, jefe de seguridad en Anthropic, estos agentes podrán actuar por su cuenta, responder a amenazas de seguridad e interactuar con sistemas críticos… como si fueran personas reales.

Pero eso plantea una pregunta inquietante:

¿Qué pasa si una IA comete un delito o vulnera un sistema?

⚠️ Riesgos en ciberseguridad: una puerta abierta al caos

Hasta ahora, si un empleado humano hackeaba un sistema o filtraba información, la ley lo podía castigar. Sin embargo, si lo hace una IA… ¿quién es el culpable? ¿El programador? ¿La empresa? ¿La propia IA?

Anthropic reconoce que aún no tienen soluciones definitivas para estos desafíos de seguridad. Entre las preocupaciones más urgentes están:

- Cómo proteger las cuentas corporativas utilizadas por IAs.

- Qué nivel de acceso deben tener a las redes internas.

- Quién debe supervisar y asumir la responsabilidad de sus actos.

- Cómo evitar que realicen acciones no autorizadas, como modificar código en entornos de pruebas o lanzar scripts de forma autónoma.

"Necesitamos nuevas herramientas que den visibilidad a lo que hace una cuenta de IA, y nuevas formas de clasificar a estos empleados virtuales", afirma Clinton.

🧠 Una IA que escribe casi todo el código

Por si fuera poco, la IA no solo cumplirá funciones de soporte, sino que también será la principal programadora en el futuro cercano. Dario Amodei, CEO de Anthropic, ha declarado que en tan solo seis meses, las IAs podrían escribir el 90% del código, y en un año prácticamente todo el código será generado por inteligencia artificial.

Esto no solo plantea un debate ético, sino también una gran vulnerabilidad si no se audita correctamente ese código generado.

🧩 Un dilema legal y laboral sin precedentes

La introducción de empleados virtuales en los organigramas empresariales no es una idea nueva. La plataforma Lattice ya intentó en 2024 integrar bots de IA como parte oficial de sus equipos de trabajo. Sin embargo, tras una oleada de quejas, tuvieron que dar marcha atrás.

¿Por qué? Porque la inclusión de IA en la plantilla aún carece de legislación clara y de protocolos de gestión empresarial sólidos. Además, genera una gran inquietud entre los trabajadores humanos, quienes temen ser reemplazados.

🛡️ ¿Estamos preparados para este cambio?

La respuesta es un rotundo no. Aunque la automatización promete eficiencia, la falta de control, legislación y vigilancia sobre las IA podría derivar en consecuencias catastróficas para la seguridad informática y para las propias empresas.

Clinton propone que, antes de dar este gran paso, se desarrollen:

- Sistemas de clasificación para cuentas de empleados de IA.

- Protocolos de auditoría y monitoreo continuo.

- Normas legales que definan responsabilidades ante incidentes causados por una IA.

🤖 Una revolución necesaria, pero peligrosa

Los empleados virtuales con IA ya no son ciencia ficción. Están a la vuelta de la esquina y prometen cambiarlo todo: desde la ciberseguridad hasta el mercado laboral.

Pero este cambio no puede hacerse a ciegas. Necesitamos legislación, tecnología y conciencia ética para evitar que esta innovación se convierta en una amenaza.

¿Estás preparado para trabajar junto a una IA que tiene memoria, decisiones propias y acceso al sistema de tu empresa?